Apple pubblica uno studio che mette in discussione la reale capacità di ragionamento dei modelli AI. The Illusion of Thinking analizza i limiti cognitivi dell’intelligenza artificiale, rivelando un collasso sistematico quando la complessità aumenta. Un’analisi tecnica e filosofica che cambia il paradigma.

Limiti cognitivi dell’intelligenza artificiale // Apple ha pubblicato un documento che potrebbe ridefinire il modo in cui interpretiamo le capacità dell’intelligenza artificiale. Il paper, intitolato The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity, è stato diffuso poco prima del WWDC 2025 e rappresenta una presa di posizione netta contro l’ottimismo dilagante sull’AI. L’azienda di Cupertino ha scelto di concentrarsi su una classe emergente di modelli, i Large Reasoning Models (LRMs), progettati per simulare processi di pensiero articolati.

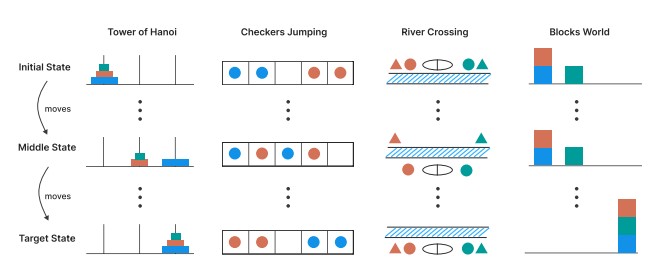

Il lavoro si distingue per la sua impostazione metodologica rigorosa: invece di affidarsi a benchmark standardizzati, Apple ha costruito un ambiente sperimentale controllato, basato su puzzle logici classici come la Torre di Hanoi, il problema del traghettamento e giochi di costruzione con blocchi. Ogni puzzle è stato progettato per mantenere una struttura logica coerente, aumentando progressivamente la complessità, in modo da testare la tenuta del ragionamento.

Il collasso oltre la soglia: limiti cognitivi dell’intelligenza artificiale

I modelli analizzati – tra cui Claude 3.7 Sonnet Thinking, OpenAI o1 e o3, DeepSeek R1 e Google Gemini Flash Thinking – sono stati sottoposti a una serie di prove che richiedevano pianificazione, memoria e coerenza logica. Il risultato è stato sorprendente: tutti i modelli hanno mostrato un collasso delle prestazioni oltre una soglia critica di difficoltà.

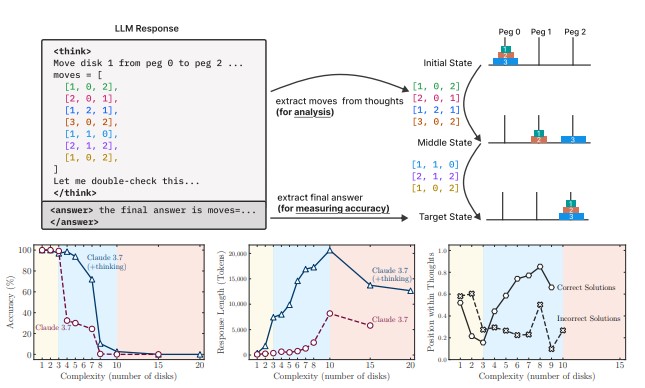

Claude 3.7, ad esempio, fallisce già con il quinto disco nella Torre di Hanoi. Ma ciò che colpisce maggiormente è il comportamento paradossale osservato: man mano che i problemi diventano più complessi, i modelli riducono l’impiego di risorse cognitive. Questo fenomeno, definito reasoning retreat, suggerisce una limitazione strutturale nella capacità dei modelli di gestire la composizionalità logica.

Il paper identifica tre regimi distinti di comportamento nei LRMs: nei compiti semplici, i modelli standard (LLMs) spesso superano i LRMs; nei compiti intermedi, i LRMs mostrano un vantaggio; nei compiti complessi, tutti i modelli collassano. Questo schema evidenzia che l’aumento delle risorse computazionali non è sufficiente a superare i limiti cognitivi dell’intelligenza artificiale.

Il titolo stesso del paper – The Illusion of Thinking – è una dichiarazione polemica. Apple contesta l’idea che i modelli attuali siano in grado di “pensare” nel senso umano del termine. Piuttosto, imitano pattern di ragionamento appresi durante l’addestramento, ma falliscono quando la complessità richiede generalizzazione e coerenza.

Lo studio ha suscitato un acceso dibattito nella comunità scientifica. Alcuni ricercatori, come A. Lawsen del MIT, hanno sollevato dubbi sulla validità del protocollo sperimentale. Apple ha replicato sottolineando che il focus non è sulla soluzione finale, ma sulla qualità del ragionamento.

Nel contesto di un’industria che spinge verso dispositivi AI-first, Apple adotta una strategia più cauta. L’introduzione di Apple Intelligence nel 2025 è avvenuta in modo selettivo, con un’enfasi sulla trasparenza e sull’etica. Questo approccio trova coerenza con le conclusioni del paper: prima di integrare l’AI in modo pervasivo, è necessario comprenderne i limiti strutturali.

Il contributo più importante del paper non è solo tecnico, ma filosofico. Apple invita a riconsiderare i criteri con cui valutiamo l’intelligenza artificiale. I limiti cognitivi dell’intelligenza artificiale non sono un ostacolo da aggirare con più potenza, ma una frontiera da comprendere con maggiore profondità.

Leggi altri articoli su tecnologia e innovazione su quasimezzogiorno.com qui.